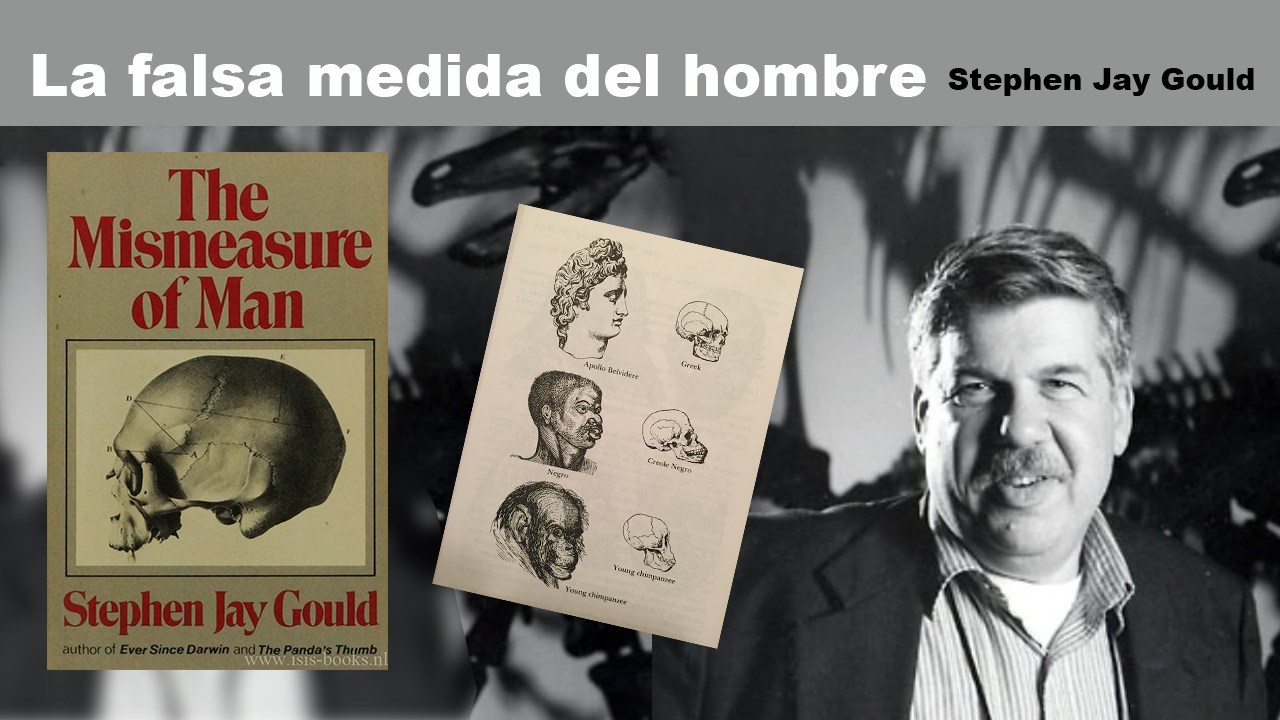

La falsa medida del hombre

Stephen Jay Gould, 1981

La revista Discover (antes de que fuera adquirida por Disney) tenía una excelente sección de recomendación y crítica de libros, y fue ahí donde me enteré de este magnífico título y de la polémica que generó en su momento.

The Mismeasure of Man (La falsa medida del hombre)

El libro The Mismeasure of Man, de Stephen Jay Gould, publicado en 1981, analiza críticamente los intentos históricos por medir y clasificar a los seres humanos según supuestas jerarquías biológicas. Como anécdota curiosa, la Dra. Candace Pert —neurocientífica famosa por descubrir los receptores de opiáceos en el cerebro— fue una de sus críticas más severas. Años después, Pert formaría parte de la Ramtha’s School of Enlightenment, responsable del pseudodocumental “What the Bleep Do We Know!?”, lo cual añade un giro irónico a la historia.

Regresando al libro, Gould explica cómo los intentos de calificar y medir a los seres humanos estuvieron desde el principio distorsionados por prejuicios que asumían la existencia de seres humanos “superiores” e “inferiores”.

La ciencia debería partir de los hechos para llegar a una conclusión, pero —como demuestra Gould— con frecuencia los investigadores partieron de una conclusión preconcebida, ajustando o incluso falseando los datos para justificarla.

Medidas y pseudociencias

El libro sigue un orden histórico y revisa varias pseudociencias que en su momento se consideraron legítimas, como la frenología o la idea del “criminal nato”.

En la Europa ilustrada, la creencia de que la mujer era un “hombre incompleto” era ampliamente aceptada; no faltaban quienes afirmaban que una mujer inteligente era tan anormal como un gorila de dos cabezas. Incluso Darwin, aunque más prudente, escribió algunas afirmaciones hoy inaceptables, aunque atribuía esas diferencias a las condiciones sociales y no a causas biológicas.

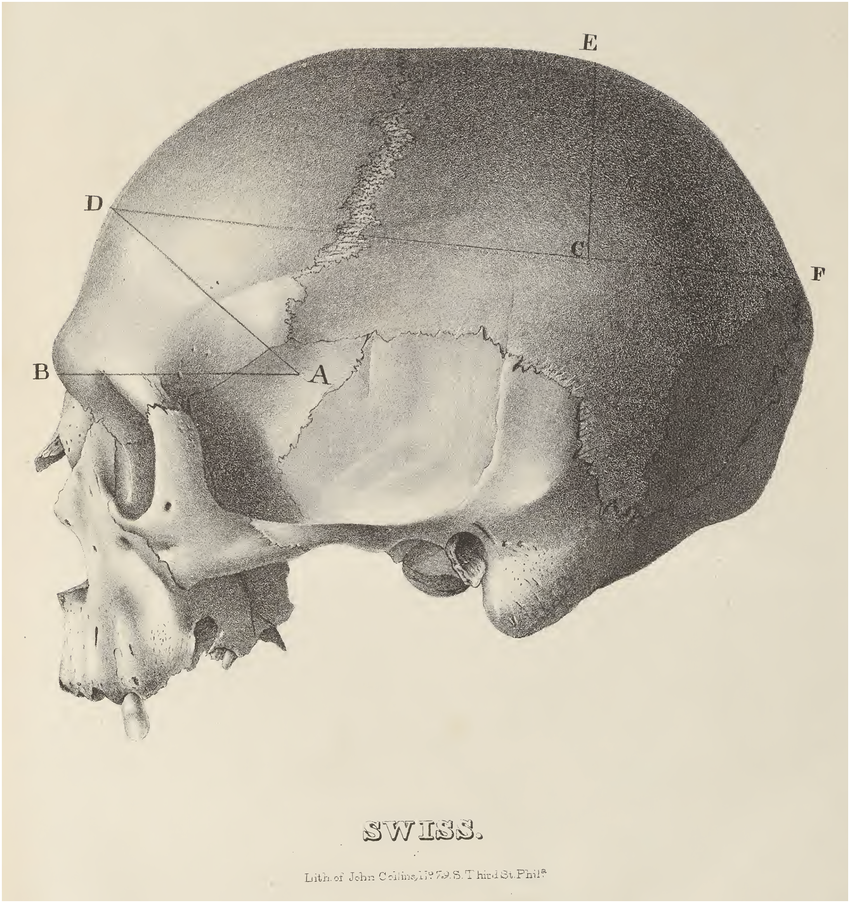

Medición del cráneo e inteligencia

Uno de los primeros intentos de medir la inteligencia consistió en calcular la capacidad craneal. Durante el siglo XIX se asumía que un cráneo más grande implicaba una mente más desarrollada, una idea que parecía lógica en una época que valoraba la cuantificación por encima de la observación crítica. Dado que las mujeres —en promedio de menor estatura y complexión— tenían cráneos más pequeños, muchos científicos concluyeron erróneamente que su inteligencia era inferior. Esa idea, revestida de objetividad, reforzaba creencias culturales ya existentes.

Entre quienes llevaron esa obsesión a un nivel sistemático estuvo el médico y naturalista estadounidense Samuel George Morton (1799–1851). Morton reunió una enorme colección de cráneos humanos de distintas regiones del mundo y los midió llenándolos con semillas o perdigones de plomo para calcular su volumen interno. A partir de esos datos, creyó encontrar evidencia de que los europeos tenían cerebros más grandes y, por tanto, eran más inteligentes que los africanos o los pueblos indígenas de América. Su obra, Crania Americana (1839), fue aclamada en su tiempo como ejemplo de ciencia rigurosa, pero en realidad se convirtió en uno de los pilares del llamado racismo científico.

Más de un siglo después, en La falsa medida del hombre, Stephen Jay Gould revisó las mediciones de Morton y concluyó que sus resultados estaban sesgados. Gould argumentó que Morton, consciente o no, había manipulado los datos al seleccionar muestras favorables a sus prejuicios, exagerando las diferencias entre “razas”. Su tesis era que la ideología racista había distorsionado la interpretación de los datos, convirtiendo la medición en justificación.

Sin embargo, décadas más tarde, en 2011, un grupo de antropólogos de la Universidad de Pensilvania —la misma institución donde trabajó Morton— reanalizó los cráneos originales y comprobó que sus mediciones eran numéricamente correctas. El error de Morton no estaba en los números, sino en las premisas: partía del supuesto de que el tamaño del cráneo medía la capacidad intelectual y de que las “razas” eran categorías biológicas fijas. Los investigadores concluyeron que, aunque Gould exageró la manipulación de Morton, su crítica sobre el sesgo cultural seguía siendo válida: Morton había tomado como evidencia lo que en realidad era interpretación.

Hoy en día, la neurociencia reconoce que existe una correlación débil entre tamaño cerebral y rendimiento cognitivo a nivel individual, pero esa relación desaparece al comparar grupos poblacionales. La inteligencia humana depende de una compleja interacción de factores genéticos, ambientales, nutricionales y culturales, no de la simple masa cerebral. Las diferencias en la forma o el volumen del cráneo reflejan principalmente la proporción corporal y la adaptación climática —por ejemplo, cráneos más alargados en climas cálidos y más anchos en climas fríos—, sin relación con la capacidad intelectual.

En resumen, el caso de Morton y Gould ilustra con claridad cómo la ciencia puede confundirse con ideología cuando se buscan jerarquías donde no las hay. La medición, por sí sola, no produce conocimiento: lo que da sentido a los datos es la pregunta que se formula. Y cuando esa pregunta nace del prejuicio, el resultado no es ciencia, sino una forma elegante de error.

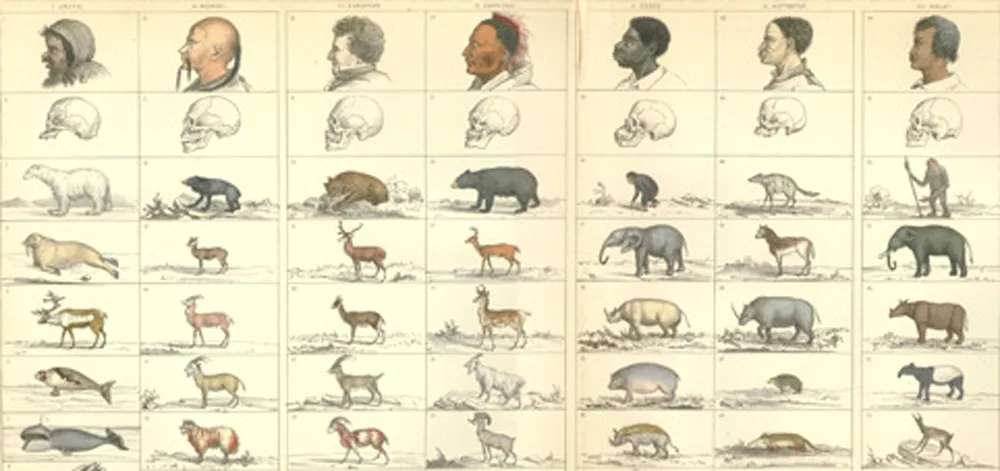

Racismo y evolución

Una de las razones del rechazo inicial a la teoría de la evolución fue que implicaba que todos los seres humanos pertenecen a una misma especie. A principios del siglo XIX, sin embargo, una corriente científica llamada poligenismo sostenía que Dios había creado a las “razas” humanas por separado, considerando a las personas negras una especie distinta. De acuerdo con esa idea, las uniones entre blancos y negros eran un pecado comparable al bestialismo.

Científicos influyentes como Louis Agassiz defendieron el poligenismo y se opusieron a Darwin precisamente porque la teoría evolutiva lo refutaba. Darwin, aunque influido por algunos prejuicios de su época, argumentaba que todos los seres humanos tenían el mismo potencial biológico para desarrollarse bajo condiciones adecuadas.

Cuando la poligenia fue abandonada, surgieron nuevas formas de clasificar a los seres humanos como “más” o “menos evolucionados”. El término “mongolismo” —hoy completamente obsoleto y ofensivo— proviene de esa visión racializada de la inteligencia, que asociaba erróneamente los rasgos faciales de personas con síndrome de Down con supuestas “razas inferiores”.

Las pruebas de inteligencia y la eugenesia

Las pruebas de inteligencia fueron desarrolladas a comienzos del siglo XX en Francia por Alfred Binet con un propósito pedagógico muy concreto: identificar a los estudiantes con dificultades de aprendizaje para brindarles apoyo adicional y permitirles alcanzar a sus compañeros. Binet insistía en que el cociente intelectual no debía verse como una medida fija o innata, sino como una herramienta educativa y perfectible.

Sin embargo, cuando sus métodos fueron adoptados en Estados Unidos por psicólogos como Lewis Terman y Henry Goddard, el objetivo cambió radicalmente. En el clima intelectual del movimiento eugenésico de principios del siglo XX, las pruebas se transformaron en instrumentos de clasificación social y racial. Se asumió que la inteligencia era un rasgo innato, hereditario y dependiente de la “raza” o del origen socioeconómico. Pobres, inmigrantes y afroamericanos fueron sistemáticamente catalogados como inferiores.

Las pruebas aplicadas a los reclutas del ejército durante la Primera Guerra Mundial parecían confirmar esos prejuicios, pero estaban plagadas de sesgos: se basaban en referencias culturales y lingüísticas propias de la clase media anglosajona, por lo que penalizaban a quienes no hablaban inglés o no conocían costumbres estadounidenses. Pese a sus defectos, esos resultados se usaron para establecer cuotas de inmigración en la década de 1920, limitando el ingreso de europeos del sur y del este, y excluyendo a miles de refugiados que huían del nazismo años después. Fue un ejemplo claro de cómo un dato mal interpretado puede tener consecuencias humanas devastadoras.

El uso político de la inteligencia alcanzó su punto más oscuro con la eugenesia aplicada dentro de Estados Unidos. Inspirados en ideas de “higiene racial”, varios estados aprobaron leyes que permitían la esterilización forzada de personas consideradas “mentalmente deficientes”, muchas veces basándose en exámenes de inteligencia dudosos. Entre 1907 y 1979, más de 60 000 estadounidenses fueron esterilizados sin su consentimiento bajo argumentos pseudocientíficos.

Hoy sabemos que la inteligencia, como muchas otras características humanas, tiene un componente hereditario, pero también está fuertemente influida por factores ambientales: nutrición, salud, educación, entorno emocional y oportunidades culturales. La investigación moderna en genética y neurociencia muestra que no existen “razas” humanas biológicamente discretas. Las diferencias genéticas entre grupos poblacionales son mínimas y no guardan relación con la capacidad intelectual. En cambio, la desigualdad histórica, la pobreza y el acceso desigual a la educación explican mucho más sobre las variaciones en los puntajes de inteligencia que cualquier factor genético.

En este sentido, Stephen Jay Gould tenía razón al denunciar el uso ideológico de la ciencia, aunque su escepticismo hacia la influencia hereditaria fue quizás excesivo. La evidencia actual invita a una visión más equilibrada: la inteligencia tiene una base biológica, pero no está determinada por la raza ni por una jerarquía genética. Lo peligroso no es estudiar la mente humana, sino usar sus resultados para justificar desigualdades que la ciencia debería ayudar a superar.

El factor G: entre la estadística y la biología

La parte final del libro, y también la más polémica, se centra en la crítica al llamado factor G propuesto por el psicólogo británico Charles Spearman a comienzos del siglo XX. Spearman observó que el desempeño de los alumnos en distintas tareas cognitivas —como vocabulario, matemáticas o razonamiento— tendía a correlacionarse. A partir de esa observación planteó que debía existir una capacidad general de inteligencia subyacente a todas ellas, a la que llamó factor general o simplemente G.

En su modelo bifactorial, Spearman postuló que todo desempeño intelectual dependía de dos elementos: el factor G, común a todas las tareas, y un conjunto de factores específicos (s) propios de cada habilidad. Con el tiempo, otros psicólogos —como Raymond Cattell y John Horn— refinaron esta idea distinguiendo entre inteligencia fluida (capacidad de razonar y resolver problemas nuevos) y inteligencia cristalizada (conocimientos adquiridos), dos dimensiones que aún hoy se usan en psicometría moderna.

Spearman y sus seguidores interpretaron el factor G como una propiedad innata del cerebro, potencialmente hereditaria y medible a través de pruebas estandarizadas. Stephen Jay Gould consideró que esta conclusión iba demasiado lejos. Para él, el factor G no era una “sustancia mental”, sino una reificación: una abstracción estadística convertida en objeto físico. En palabras simples, Gould aceptaba las correlaciones entre tareas, pero rechazaba la idea de que reflejaran una única entidad biológica o un valor absoluto de inteligencia.

Las décadas siguientes confirmaron que Gould tenía motivos para su cautela. Los modelos estadísticos modernos sostienen la existencia del factor G como un constructo útil y reproducible, pero no como una “esencia” medible dentro del cerebro. La neurociencia contemporánea muestra que el rendimiento cognitivo depende de redes distribuidas —atención, memoria, control ejecutivo— más que de una sola fuente común.

Asimismo, estudios genéticos recientes indican que la inteligencia tiene un componente hereditario moderado (entre 40 y 70 %), aunque esto no implica diferencias significativas entre poblaciones humanas ni sustenta ideas de “razas más inteligentes”. Las variaciones en los puntajes de inteligencia se deben mucho más a factores sociales, educativos y ambientales que a la biología pura. Los intentos de usar el factor G para justificar jerarquías raciales o políticas eugenésicas representan un abuso ideológico de la ciencia, precisamente el tipo de distorsión que Gould denunció con tanta lucidez.

En la actualidad, el consenso científico reconoce que el factor G es un patrón estadístico real y útil para describir diferencias cognitivas individuales, pero no una medida del valor humano ni un marcador genético o racial. En ese sentido, la crítica de Gould sigue vigente: la inteligencia puede estudiarse, pero nunca debe utilizarse como pretexto para clasificar o excluir.

Conclusión

A pesar de las críticas recibidas, La falsa medida del hombre sigue siendo una lectura fundamental para comprender cómo el quehacer científico puede ser distorsionado —a veces sin mala intención— por los prejuicios culturales, sociales o ideológicos de su tiempo. Gould nos recuerda que la ciencia no está libre de sesgos humanos, y que reconocerlos es el primer paso para superarlos, tambien debemosrecordar que incluso el propio Gould podia caer bajo algunos sesgos.